DFG- Projekt: OptNeToL: Durchgängige, OPTimierungsbasierte NEnnmaß- und TOLeranzvergabe | Projektende im Dezember 2023

Damit technische Systeme trotz Fertigungsungenauigkeiten ihre Funktion erfüllen, werden die unvermeidbaren, geometrischen Abweichungen gezielt durch Form-, Maß- und Lagetoleranzen eingeschränkt. Allerdings werden dadurch bereits die Anforderungen für die anschließende Fertigung und somit implizit die Herstellungskosten festgelegt. Die Methode der Toleranz-Kosten-Optimierung schafft den Spagat zwischen geringen Kosten und hoher Produktqualität, indem sie alle Toleranzwerte kostenoptimal und automatisiert aufeinander abstimmt. Bislang konnten die dafür entwickelten Lösungsansätze jedoch nicht zur umfassenden Beantwortung praxisrelevanter Fragestellungen genutzt werden. Einschränkungen in Genauigkeit, Vollständigkeit und Effizienz, sowie die fehlende Einbindung in den modernen Produktentwicklungsprozess erschweren die Lösung industrieller Problemstellungen, wodurch verborgene Kostenpotentiale zumeist ungenutzt bleiben.

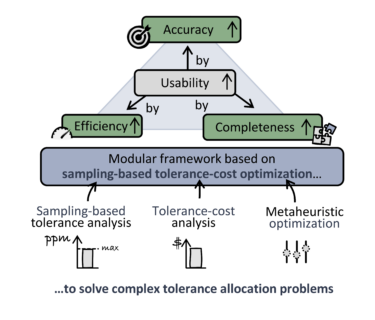

Um diese Hürden zu überwinden, wurden im Rahmen eines zweieinhalbjährigen DFG-Projekts die Erkenntnisse aus dem vorhergehenden Projekt „Toleranzoptimierung statisch unter- und überbestimmter Systeme“ genutzt und die Methode der samplingbasierten Toleranz-Kosten-Optimierung weiterentwickelt. Zum einen erlauben die neuen Methoden ihren Einsatz bei lediglich approximativ vorliegenden Kosteninformationen sowie die Festlegung von robusten Nennmaßen und damit ihre Anwendung in frühen Produktdesignphasen. Zum anderen befähigt die Integration von Form- und Lagetoleranzen sowie von Maschinenselektions- und –allokationsstrategien mit maschinenspezifischen Fertigungsverteilungen die Anwendung auf komplexe, nichtlineare Baugruppen bei zugleich frühzeitiger Berücksichtigung von Herstellungsrandbedingungen. Dabei stellt die Abstimmung der Optimierungsroutinen mit varianzreduzierenden Sampling- und Ausschussratenschätzverfahren die Verlässlichkeit der Optimierungsergebnisse sicher. Durch neuartige Effizienzsteigerungsmethoden basierend auf adaptiven Stichprobengrößen und Metamodellen können die Rechenzeiten signifikant reduziert werden, ohne dabei die Aussagequalität der Ergebnisse zu beeinträchtigen. Die abschließende Evaluation des entwickelten und in einen Softwareprototyp überführten Gesamtrahmenwerks zeigt, dass die erforschten Methoden wesentlich zur universellen Anwendbarkeit beitragen und nun Produktentwickelnde ohne vertiefte Kenntnisse in Statistik und Optimierung Nennmaße- und Toleranzen robust und kostenoptimal festlegen können. Link: https://doi.org/10.1016/j.procir.2022.10.029