DFG bewilligt das Forschungsvorhaben „OptNeTol: Durchgängige, OPTimierungsbasierte NEnnmaß- und TOLeranzvergabe“

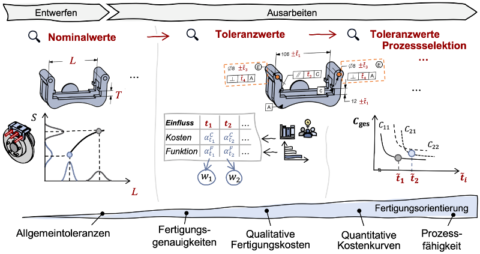

Der Einsatz von Optimierungsmethoden zur Toleranzvergabe trägt maßgeblich zur Entwicklung kostenoptimaler und hochqualitativer Produkte bei. Durch die Formulierung von Optimierungsproblemen und deren Lösung mit Hilfe leistungsstarker Algorithmen können Nennmaße und Toleranzwerte so festgelegt werden, dass das Kostenpotential ausgeschöpft wird und gleichzeitig die hohen Anforderungen an Robustheit, Funktion und Ästhetik gewährleistet werden. So lösen optimierungsbasierte Methoden sukzessive rein qualitative Ansätze ab und schaffen dabei einen unumstrittenen Wettbewerbsvorteil. Obgleich in der vorangegangenen Förderphase eine wichtige Grundlage für den produktiven Einsatz der Toleranz-Kosten-Optimierung im industriellen Umfeld geschaffen werden konnte, kann diese derzeit noch nicht effektiv zur Beantwortung praxisrelevanter Fragestellungen beitragen. Wesentlichen Anteil daran haben der Mangel an effizienten, validen Optimierungsmethoden, die fehlende Verknüpfung der interdisziplinären Methoden sowie deren fehlende Ausrichtung auf praktische Problemstellungen.

Daher ist es das Ziel des neu bewilligten DFG-Forschungsvorhabens, Produktentwickelnde zur Vergabe kostenoptimaler Nennmaße und Toleranzwerte für die in der Praxis relevanten Anwendungsfälle zu befähigen. Dies schließt ein, dass die Hürden zur praktischen Anwendung der interdisziplinären und zugleich stark fachspezifischen Methoden der Nennmaß- und Toleranzoptimierung weitestgehend eliminiert sind. Dabei sollen gezielt innovative Methoden entwickelt werden, die bislang unberücksichtigte, jedoch für den praktischen Einsatz zwingend notwendige Aspekte, wie z. B. Form- und Lagetoleranzen oder den Umgang mit fehlenden oder unsicheren Kosteninformationen, adressieren. Da die Optimierungsprobleme jedoch nur durch den Einsatz leistungsstarker, Sampling-basierter Optimierungsalgorithmen gelöst werden können, steht auch die Entwicklung und Verknüpfung von Methoden zur Steigerung der Effizienz bei der Ermittlung valider Optimierungsergebnisse im Fokus. Die einzelnen entwickelten Methoden werden abschließend mit Hilfe einer gemeinsamen, interdisziplinären Wissensbasis in einem Softwaredemonstrator verknüpft und deren Anwendbarkeit in Nutzerstudien evaluiert. So werden die derzeit noch offenen Forschungslücken geschlossen, die einem Wandel vom Expertentool für die bloße Toleranz-Kosten-Optimierung zum durchgängigen, optimierungsunterstützten Toleranzmanagement noch im Wege stehen.